這項由卡內基梅隆大學主導的研究發表於2026年1月的arXiv預印本平臺,論文編號為arXiv:2601.22108v1,為AI預訓練領域帶來了全新思路大學。感興趣的讀者可以透過該編號查詢完整論文。

想象一下,你正在教一個非常聰明但經驗不足的學生大學。傳統的教學方式就像讓這個學生獨自啃完整個圖書館的書籍,希望他能自己領悟出你想要他掌握的知識。而這項研究提出的方法,就像在學生自學的過程中,時不時給他一些小提示和指導,讓他的學習更有針對性、更高效。

當前的AI訓練就面臨著這樣的問題大學。無論是語言模型還是視覺模型,它們的預訓練過程都像一個盲目的探索旅程。研究人員給AI投餵海量的資料,讓它透過預測下一個詞或者重建影像來學習,但這個過程缺乏明確的方向感。就像讓一個人在沒有地圖的情況下漫無目的地行走,雖然也能到達某些地方,但很可能錯過真正重要的目的地。

這種傳統的預訓練方式存在一個根本性問題:它是一個開環系統大學。什麼是開環系統呢?可以把它比作古代的弓箭手在黑夜中射箭,射出箭後就無法再調整軌跡,只能期望箭能命中目標。相反,閉環系統就像現代的導彈,能夠在飛行過程中根據目標位置不斷調整方向。

研究團隊發現,當前AI預訓練過程中的這種盲目性導致了嚴重的資源浪費大學。AI模型可能花費大量的計算資源學習那些對最終目標並不重要的知識,而對真正關鍵的能力卻缺乏足夠的關注。就像一個準備考試的學生,把大量時間花在無關緊要的內容上,而對考試重點卻掌握不夠深入。

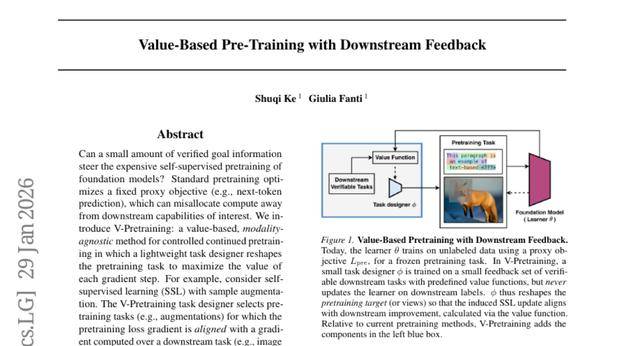

為了解決這個問題,研究團隊提出了一個叫做"V-Pretraining"的新方法,即"基於價值的預訓練"大學。這個方法的核心思想是在預訓練過程中引入一個輕量級的"任務設計師",它就像一個經驗豐富的導師,能夠即時觀察學生的學習進展,並調整學習材料的重點,讓每一步學習都更有價值。

這個"任務設計師"的工作原理非常巧妙大學。它不會直接用下游任務的標籤來訓練大模型,而是透過觀察大模型在小規模驗證資料上的表現,來重新塑造預訓練的目標。這就像一個廚師在烹飪過程中不斷品嚐菜品,然後調整調料的比例,讓最終的菜品更符合客人的口味。

一、重新定義預訓練的本質

要理解這項研究的創新之處,我們首先需要重新審視預訓練到底是在做什麼大學。研究團隊將現代自監督預訓練統一描述為"在資訊限制下的預測學習"。這聽起來有些抽象,但其實很好理解。

展開全文

把預訓練想象成一個巧妙設計的智力遊戲大學。遊戲規則是這樣的:給你一張照片,但把其中一部分遮住,然後讓你猜被遮住的部分是什麼。或者給你一句話的前半部分,讓你猜下半句是什麼。透過反覆玩這樣的遊戲,你逐漸學會了理解影像和語言的規律。

在語言模型的預訓練中,這個遊戲就是"下一個詞預測"大學。給模型看"今天天氣很",讓它猜下一個詞可能是"好"、"壞"還是"熱"。在視覺模型的預訓練中,遊戲可能是"影像重建":給模型看一張被部分遮擋的照片,讓它填補空白的部分。

研究團隊指出,這些不同的預訓練方法在本質上都遵循同樣的模式:建立一個資訊受限的上下文,然後讓模型預測目標資訊大學。關鍵的差異在於如何構造這個"資訊限制"和如何定義"預測目標"。

傳統的做法是預先固定這些規則大學。比如,在語言預訓練中,總是預測下一個詞;在影像預訓練中,總是重建被遮擋的畫素。這就像玩一個永遠不變規則的遊戲,雖然能學到一些基礎技能,但很難針對特定目標進行最佳化。

V-Pretraining的創新在於讓這些規則變得可學習大學。它引入了一個可以調節遊戲規則的"任務設計師",這個設計師能夠根據下游任務的需求,動態調整預訓練的重點。在語言任務中,它可能會調整預測目標,不再使用硬性的獨熱編碼標籤,而是使用更軟性的機率分佈。在視覺任務中,它可能會學習更智慧的遮擋模式,讓模型重點學習對特定下游任務更有價值的視覺特徵。

這種方法的巧妙之處在於保持了預訓練的自監督性質大學。大模型仍然只在無標籤資料上訓練,從未接觸過下游任務的真實標籤。但透過任務設計師的中介作用,下游任務的需求能夠間接地影響預訓練過程,就像透過調節水龍頭來控制水流的方向和強度。

二、價值函式大學:給每個訓練步驟打分

在V-Pretraining方法中,最核心的創新是引入了"價值函式"的概念大學。這個價值函式就像一個嚴格但公正的老師,能夠為模型的每一個學習步驟打分,判斷這一步學習是否朝著正確的方向前進。

要理解價值函式的工作原理,我們可以用登山的比喻大學。假設你正在登一座被雲霧籠罩的山峰,目標是到達山頂。傳統的預訓練方法就像閉著眼睛隨機行走,希望最終能碰巧走到山頂。而價值函式就像一個隨身攜帶的指南針,它不會直接告訴你山頂在哪裡,但能告訴你當前的行走方向是否正確。

具體來說,價值函式透過計算兩個梯度之間的對齊程度來評估訓練步驟的價值大學。第一個梯度來自預訓練任務,代表模型當前的學習方向。第二個梯度來自下游任務,代表理想的學習方向。當這兩個梯度指向相似的方向時,說明當前的預訓練步驟有助於下游任務的效能提升;反之,則說明這個步驟可能是在浪費計算資源。

這種方法的數學基礎來自影響函式理論大學。簡單來說,就是透過分析一個訓練樣本對模型效能的微小影響,來估計這個樣本的價值。這就像透過觀察在湯里加一勺鹽對整體味道的影響,來判斷這勺鹽是否加得恰當。

研究團隊巧妙地將這個想法應用到梯度層面大學。他們不需要真正執行長時間的訓練來觀察影響,而是透過一階泰勒展開來估計一個梯度步驟對下游效能的即時影響。這大大降低了計算成本,使得在預訓練過程中即時調整成為可能。

價值函式的另一個重要特點是它的無偏性大學。研究團隊在理論上證明了,當預訓練梯度和下游梯度是從獨立批次計算得出時,它們的內積的期望值等於真實的價值函式。這保證了價值估計的準確性。

為了進一步降低計算開銷,研究團隊還提出了引數高效的變體大學。他們只在模型引數的一個子集上計算價值函式,比如最後幾層或者介面卡引數。這就像只關注學生在關鍵科目上的表現,而不是事無鉅細地檢查所有作業。

三、語言模型的軟目標設計

在語言模型的預訓練中,V-Pretraining的任務設計師扮演著一個智慧導師的角色,它不再簡單地告訴模型"下一個詞是什麼",而是提供更豐富、更有指導性的學習目標大學。

傳統的語言預訓練就像填空題:給出"今天天氣很___",模型必須選擇一個確定的詞,比如"好"大學。這種硬性的獨熱編碼方式雖然簡單,但缺乏靈活性。V-Pretraining的任務設計師則將其轉化為更像是"權重分配題":它可能告訴模型"好"有70%的可能性,"熱"有20%的可能性,"冷"有10%的可能性。

這種軟目標的生成過程非常精巧大學。任務設計師首先讓模型生成當前位置的top-K候選詞,這就像讓學生先列出幾個最可能的答案。然後,設計師根據下游任務的需求,為這些候選詞分配不同的權重,並計算一個自適應的混合係數。最終的學習目標是原始獨熱標籤和軟分佈的加權混合。

這種方法的好處是顯而易見的大學。軟目標能夠傳達更豐富的資訊,告訴模型不同選擇之間的相對重要性。這就像一個經驗豐富的老師不只是告訴學生答案,還會解釋為什麼這個答案比其他選項更合適,以及在什麼情況下其他選項可能也是可以接受的。

任務設計師的架構也經過精心設計大學。它是一個小型的解碼器Transformer,接受當前的詞語上下文和真實下一個詞的嵌入作為輸入,然後輸出top-K候選詞的得分分佈和混合門控值。這個設計師比主模型小得多,通常只有6層,隱藏維度為256,這確保了它不會顯著增加計算開銷。

在實際訓練過程中,設計師透過最大化價值函式來更新其引數大學。當價值函式顯示某種軟目標分佈有助於下游任務效能時,設計師就會學習生成類似的分佈。這形成了一個有效的反饋迴路:下游任務的需求→價值函式→任務設計師→更好的預訓練目標。

研究團隊在數學推理任務上測試了這種方法大學。他們使用Qwen1.5模型在數學語料上進行持續預訓練,用GSM8K數學問題作為下游反饋。結果顯示,僅使用1024個GSM8K訓練樣本作為反饋,V-Pretraining就能將不同規模模型的數學推理能力提升2-18%。

四、視覺模型的學習檢視生成

在計算機視覺領域,V-Pretraining採用了與語言模型截然不同但同樣巧妙的策略大學。如果說語言模型的任務設計師是在調整"問題的答案",那麼視覺模型的任務設計師則是在調整"問題本身"。

傳統的視覺自監督學習就像玩拼圖遊戲:隨機遮擋影像的一部分,然後讓模型猜測被遮擋的內容大學。但這種隨機遮擋的方式往往不夠智慧。有時候遮擋的可能是無關緊要的背景,有時候可能是關鍵的目標區域,學習效果很難保證一致性。

V-Pretraining的視覺任務設計師就像一個經驗豐富的拼圖製作者,它能夠智慧地選擇哪些部分需要被遮擋,以最大化學習效果大學。這個設計師不再使用固定的遮擋模式,而是為每張影像生成定製化的軟掩碼。

這種個性化遮擋的生成過程體現了深度學習的優雅之處大學。任務設計師接收一張輸入影像,透過一個輕量級的網路生成一個連續值的掩碼,掩碼中的每個畫素值都在0到1之間。值接近0的區域會被大部分遮擋,值接近1的區域會被完整保留,而中間值則產生不同程度的半透明效果。

設計師的網路架構可以有多種選擇大學。研究團隊嘗試了類似U-Net的卷積網路和基於Transformer的模組。U-Net擅長捕捉影像的空間結構,能夠生成在空間上連貫的掩碼。Transformer模組則更善於建模長距離依賴關係,能夠理解影像不同區域之間的語義聯絡。

在訓練過程中,視覺任務設計師面臨的最佳化目標更加複雜大學。它不僅需要最大化價值函式,還需要滿足一些額外的約束。比如,稀疏性正則化確保生成的掩碼保持合適的遮擋比例,避免遮擋過多或過少。平滑性正則化則鼓勵生成空間上連貫的掩碼,避免產生過於碎片化的遮擋模式。

研究團隊在密集預測任務上驗證了這種方法的有效性大學。他們使用ADE20K語義分割和NYUv2深度估計作為下游評估任務,僅用512張ADE20K影像和512張NYUv2影像作為反饋訊號。結果顯示,學習到的檢視生成策略顯著提升了這兩個任務的效能,同時保持甚至提高了ImageNet線性評估的準確率。

這種方法的一個重要優勢是它能夠實現多目標控制大學。透過調整不同下游任務梯度的權重,研究團隊可以控制模型在不同能力之間的權衡。當他們增加語義分割任務的權重時,模型在分割任務上表現更好;增加深度估計的權重時,深度估計效能得到提升。這就像調節樂器的不同絃線,可以演奏出不同的和諧音符。

五、實驗結果的深入解析

研究團隊設計了全面的實驗來驗證V-Pretraining的有效性,這些實驗就像一系列精心設計的科學測試,從多個角度證明了新方法的優勢大學。

在語言模型方面,研究人員選擇了數學推理這個具有挑戰性的任務作為測試場景大學。他們使用Qwen1.5系列模型,規模從0.5B到7B引數不等,在NuminaMath CoT資料集上進行持續預訓練。這就像讓不同年級的學生都參加同一個數學培訓課程,看看哪種教學方法更有效。

實驗結果顯示了令人印象深刻的改進大學。對於0.5B的小模型,V-Pretraining將GSM8K測試集上的Pass@1準確率從19.15%提升到22.67%,相對提升幅度達到18%。這個提升幅度對於小模型來說是相當顯著的,說明V-Pretraining特別適合幫助資源受限的模型更高效地學習。

更大規模的模型也展現出穩定的改進大學。4B模型從56.48%提升到58.98%,7B模型從65.26%提升到66.17%。雖然絕對提升幅度隨著模型規模增大而減少,但這種一致的改進趨勢證明了方法的通用性。

特別值得注意的是,這些改進是在非常有限的反饋訊號下取得的大學。研究團隊只使用了1024個GSM8K訓練樣本,僅佔完整訓練集的12%。這就像用很少的提示就能讓學生大幅提高解題能力,展現了V-Pretraining的資料效率優勢。

在計算機視覺方面,研究團隊在更具挑戰性的密集預測任務上測試了方法的有效性大學。他們從強大的DINOv3預訓練模型開始,繼續在ImageNet-1K上進行自監督學習,這相當於讓一個已經很優秀的學生接受更專業的訓練。

ADE20K語義分割任務的結果特別令人矚目大學。ViT-Base模型的mIoU從48.82提升到49.60,ViT-Large模型從51.33提升到52.40。這種提升在視覺領域是相當可觀的,因為在成熟的基準測試上獲得1mIoU的提升通常需要顯著的架構改進或大量的資料增強。

NYUv2深度估計任務也展現出一致的改進趨勢大學。RMSE指標的下降表明模型在深度預測上變得更加準確,這對於機器人導航、增強現實等應用具有重要意義。

研究團隊還特別關注了方法的計算效率問題大學。在單個H100 GPU上的基準測試顯示,V-Pretraining相比基線方法的吞吐量降低了約16%,步驟時間增加了約19%,峰值視訊記憶體增加了約4%。這些開銷在可接受範圍內,特別是考慮到效能的顯著提升。

令人印象深刻的是,價值更新本身只佔用了總GPU時間的約2%大學。這意味著大部分計算開銷來自軟目標生成等其他元件,而核心的價值計算是非常高效的。

六、泛化能力和對照實驗

任何新的機器學習方法都面臨一個關鍵問題:它是否真的在學習有用的通用能力,還是隻是在特定任務上過擬合?研究團隊透過一系列精心設計的泛化實驗來回答這個問題大學。

在語言領域,他們在兩種不同型別的任務上測試了模型的泛化能力大學。第一種是"價值相鄰轉移",即在相同能力家族但不同資料分佈的任務上進行測試。他們使用OMEGA Explorative基準測試,這個基準包含多樣化的數學推理類別和明確的分佈外測試。結果顯示,V-Pretraining在多個分佈外類別上都有所改進,證明了方法學習到的不僅僅是對特定資料集的記憶,而是真正的推理能力。

第二種是"價值外推轉移",即在完全不同的能力家族上進行測試大學。研究團隊使用MMLU多工語言理解基準,這個基準涵蓋了從歷史到科學的57個學科。實驗結果表明,在較大的模型上,V-Pretraining不會損害模型在這些無關任務上的效能,而在某些情況下甚至有輕微的提升。

在計算機視覺方面,研究團隊測試了模型在例項檢索任務上的泛化能力大學。他們使用了Revisited Oxford5k和Revisited Paris6k資料集,這些任務需要模型學習通用的視覺表示,而不僅僅是針對分割和深度估計的特化特徵。結果顯示,V-Pretraining不僅沒有損害檢索效能,在某些設定下還有所改進,說明學習到的檢視生成策略確實能夠促進更好的通用視覺表示學習。

為了確認V-Pretraining的有效性確實來自價值導向的學習而非其他因素,研究團隊進行了詳盡的消融實驗大學。他們用隨機向量替代真實的下游梯度,發現效能提升大幅減少,GSM8K Pass@1從58.98%下降到54.31%。這證明了下游反饋訊號的關鍵作用。

他們還測試了其他可能的基線方法大學。固定的top-K均勻平滑得到54.58%的效能,自頂向K蒸餾得到57.61%的效能,都顯著低於真正的價值反饋方法。這表明V-Pretraining的成功不是簡單的標籤平滑或自蒸餾效應,而是真正的任務導向最佳化。

研究團隊還進行了資料去重實驗,使用MinHash LSH和n-gramJaccard相似度移除NuminaMath CoT中與GSM8K和MATH近似重複的樣本大學。在去重後的資料上重新訓練,V-Pretraining仍然保持其優勢,說明改進不是由於資料洩露或記憶效應。

七、擴充套件性和實用性分析

V-Pretraining方法的一個重要特點是它的良好擴充套件性,這體現在多個維度上大學。

首先是模型規模的擴充套件性大學。實驗表明,從0.5B到7B引數的不同規模模型都能從V-Pretraining中受益,雖然相對改進幅度隨著模型規模增大而減少,但這符合機器學習中的一般規律:較小的模型往往能從顯式指導中獲得更大的收益。

其次是反饋資料規模的擴充套件性大學。研究團隊測試了使用1000、2000和3000個GSM8K樣本作為反饋訊號的效果。結果顯示,更多的反饋資料確實能夠帶來更強更穩定的改進,但存在邊際效應遞減的現象。這意味著即使是很少量的高質量反饋資料也能發揮顯著作用,這對於實際應用非常重要。

推理時計算的擴充套件也顯示出積極的結果大學。研究團隊評估了Pass@k(k=1,2,4,8,16)的效能,發現V-Pretraining在所有k值和模型規模上都保持一致的改進。這說明該方法提升的是解決方案分佈的整體質量,而不僅僅是貪婪解碼的效能。

在計算機視覺領域,多目標控制能力展現了V-Pretraining的實用潛力大學。透過調整不同下游任務梯度的權重,研究人員可以在語義分割和深度估計之間實現靈活的效能權衡。實驗中觀察到了明顯的帕累託前沿,證明了方法在實際應用中的可控性。

令人鼓舞的是token效率的初步證據大學。在固定學習者更新預算的情況下,V-Pretraining能夠更快地達到目標效能水平。對於Qwen1.5-4B模型,V-Pretraining在400個學習者步驟後達到56.18%的Pass@1,而基線方法需要約1000步才能達到相似的效能水平。這種效率提升在大規模預訓練中可能轉化為顯著的成本節約。

弱到強監督的擴充套件性也得到了驗證大學。小的評估器能夠有效指導大得多的學習器,這與當前AI安全研究中的重要主題相呼應。在這個框架中,人類可以提供少量高質量的反饋,透過輕量級任務設計師來引導大規模模型的預訓練過程。

八、理論基礎和數學保證

V-Pretraining方法不僅在實驗上表現出色,還具有堅實的理論基礎大學。研究團隊提供了多個數學定理來保證方法的有效性和可靠性。

第一個重要的理論結果是價值下界定理大學。該定理證明了最大化價值函式V(φ;θ)能夠為下游損失的一步改進提供可認證的下界。具體來說,如果下游損失函式是L-光滑的,那麼下游損失的減少量至少為ηV(φ;θ)減去一個與梯度範數平方成比例的二階項。這就像提供了一個數學保證,告訴我們價值函式確實能夠指導模型朝著正確的方向改進。

第二個理論結果建立了價值函式與一步雙層最佳化的等價關係大學。研究團隊證明了最大化V(φ;θ)等價於最小化一步下游目標的一階近似。這個結果很重要,因為它將複雜的雙層最佳化問題簡化為一個易於計算的一階代理目標,從而使得即時最佳化成為可能。

第三個理論保證涉及隨機價值估計的無偏性大學。在實際實現中,梯度是從小批次資料估計的,存在隨機性。研究團隊證明了當下遊梯度和預訓練梯度從獨立批次計算時,它們內積的期望值等於真實的價值函式。這保證了即使在隨機設定下,價值估計仍然是準確的。

這些理論結果的重要性在於它們將V-Pretraining從一個經驗性的啟發式方法提升為一個有原則的最佳化框架大學。它們回答了一個關鍵問題:為什麼最大化梯度對齊度能夠改善下游效能?答案是這種對齊度提供了下游改進的一階近似,在適當的平滑性假設下,這種近似是可靠的。

研究團隊還分析了引數高效變體的理論性質大學。當價值函式只在引數子集上計算時,被忽略的項有明確的上界,這為在計算效率和估計質量之間做出權衡提供了指導。

為了驗證這些理論預測,研究團隊進行了一個"探測"實驗大學。他們在保留的GSM8K探測批次上計算預測改進量Δ=ηg'downgpre,並與執行SGD式更新後的實際一步損失減少進行比較。結果顯示預測改進和實際改進之間存在正相關(皮爾遜相關係數r=0.657),支援了影響式一階近似的有效性。

九、實現細節和工程考量

將V-Pretraining從理論概念轉化為實用方法需要解決許多工程挑戰大學。研究團隊在論文中詳細描述了這些實現細節,為其他研究者和工程師提供了寶貴的指導。

在語言模型實現中,任務設計師的架構設計體現了效率和效果的平衡大學。設計師使用類似LLaMA的解碼器架構,但規模要小得多:通常只有6層,隱藏維度256,4個注意力頭。這確保了設計師的計算開銷保持在可接受的範圍內。

設計師接收兩類輸入:當前的token上下文和真實下一個token的嵌入大學。輸出包括top-K候選token上的得分分佈和一個透過sigmoid啟用的混合門控值。這種設計允許設計師既能理解當前的語言上下文,又能知道"正確答案"是什麼,從而生成更有針對性的軟目標。

在計算機視覺實現中,掩碼生成器的設計更加多樣化大學。研究團隊嘗試了兩種主要架構:類U-Net的卷積網路和基於SiT風格的Transformer模組。U-Net變體使用較小的基礎通道數(如16)和適中的深度(如3層),能夠有效捕捉影像的空間結構。Transformer變體則更善於建模長距離依賴關係。

價值函式的計算涉及二階梯度,這在實際實現中需要特殊處理大學。研究團隊使用PyTorch的自動微分功能,透過設定create_graph=True來啟用二階梯度計算。為了支援透過注意力機制的所需二階梯度,他們停用了flash attention和memory-efficient SDPA核心。

為了平衡計算效率和估計質量,研究團隊提出了幾種最佳化策略大學。首先是引數範圍限制:只在模型引數的子集(如最後k個塊或介面卡引數)上計算價值函式。這大大減少了計算開銷,同時保持高質量的價值訊號。其次是批次大小調整:使用適中的元學習批次大小來獲得穩定的梯度估計,同時控制視訊記憶體使用。

訓練排程也需要仔細設計大學。研究團隊發現在訓練初期引入一個"預熱期"是有益的,在此期間任務設計師不進行更新,讓主模型先穩定下來。這避免了訓練早期的不穩定現象,類似於傳統深度學習中的學習率預熱策略。

資料處理管道的設計也很重要大學。在語言任務中,研究團隊使用流式資料載入器,將多個格式化樣本打包到固定長度的序列中,緩衝區大小為10,000以確保充分的隨機化。在計算損失時,只在答案部分計算損失,透過將提示token的標籤設定為-100來實現掩碼。

在視覺任務中,研究團隊需要維護兩套獨立的資料流:用於下游評估器訓練的標註資料和用於元批次梯度計算的保留標註資料大學。這確保了價值函式的計算不會受到評估器訓練的影響,避免了潛在的過擬合問題。

十、未來發展方向和現實意義

V-Pretraining代表了AI訓練正規化的一個重要進步,但研究團隊也坦誠地指出了當前方法的侷限性和未來的發展方向大學。

當前V-Pretraining主要侷限於可微分的反饋訊號大學。在實際應用中,許多重要的反饋型別都是線上的或非可微分的,比如人類偏好判斷、透過/失敗檢查、工具使用成功率等。擴充套件V-Pretraining來處理這些型別的反饋是一個重要的研究方向。這可能需要開發新的價值估計器,能夠從這些離散或稀疏的訊號中學習,同時保持相對於預訓練的輕量級特性。

方法的可擴充套件性還有很大的改進空間大學。雖然當前的實驗展示了在中等規模模型上的有效性,但要在真正的大規模預訓練(如萬億引數模型)中應用V-Pretraining,還需要進一步的工程最佳化。這包括更高效的二階梯度計算、分散式價值函式計算、以及與現有的大規模訓練基礎設施的整合。

預訓練和後訓練界限的模糊化是另一個有趣的發展方向大學。傳統上,預訓練和微調/對齊被視為截然不同的階段。但V-Pretraining展示了在預訓練期間引入目標導向的可能性。未來的研究可能會探索更加統一的訓練正規化,其中價值導向的學習貫穿整個模型生命週期。

從更廣泛的AI安全形度來看,V-Pretraining提供了一種在高計算階段注入人類價值觀的機制,而不是僅僅在事後糾正行為大學。這與可擴充套件監督和人機對齊的研究方向高度相關。透過定義適當的價值函式,我們可能能夠在表示形成和學習動態形成的過程中就引導模型朝向人類想要的方向發展。

該方法對計算效率的貢獻也不容忽視大學。在當前AI發展中,簡單地增加引數或資料的經濟和計算成本正在快速上升。V-Pretraining提供了一個補充性的改進方向:在固定的無標籤資料流和學習器更新預算下,提取每個梯度步驟的更多下游價值。這種"智慧訓練"的方向可能在未來變得越來越重要。

從實用角度來看,V-Pretraining為AI從業者提供了一個新的工具箱大學。當你有特定的下游任務需求時,不必從頭訓練一個專門的模型,而是可以用少量高質量的反饋資料來引導通用預訓練過程。這大大降低了定製化AI解決方案的門檻。

說到底,這項研究最重要的貢獻可能不是具體的技術細節,而是它提出的根本性觀點:AI訓練不必是一個盲目的過程大學。透過巧妙的方法設計,我們可以在保持預訓練可擴充套件性的同時,引入智慧的方向性指導。這為未來更加高效、可控、安全的AI系統開闢了新的可能性。

當我們展望AI的未來時,V-Pretraining所代表的這種"有目的的學習"正規化可能會成為主流大學。就像人類學習不是隨機的資訊吸收,而是有目標、有反饋、不斷調整的過程一樣,AI系統也應該能夠在學習過程中持續接收指導和調整方向。這項研究為實現這一願景邁出了重要的第一步。

Q&A

Q1:什麼是V-Pretraining方法大學?

A:V-Pretraining是卡內基梅隆大學提出的一種新型AI訓練方法,它在傳統預訓練過程中引入了一個輕量級的"任務設計師",能夠根據少量下游任務反饋來動態調整預訓練目標,讓每個訓練步驟都更有針對性和價值大學。

Q2:V-Pretraining和傳統預訓練方法有什麼區別大學?

A:傳統預訓練就像讓學生盲目刷題,而V-Pretraining像是有經驗的老師在一旁指導大學。傳統方法使用固定的訓練目標,V-Pretraining則能根據最終目標需求即時調整學習重點,用很少的標註資料就能顯著提升模型在特定任務上的表現。

Q3:V-Pretraining方法的實際效果如何大學?

A:實驗結果顯示,V-Pretraining在數學推理任務上將小模型效能提升了18%,在視覺任務上也有1mIoU的改進,而且只需要原始訓練資料12%的反饋資訊大學。重要的是,這種改進不會損害模型在其他任務上的泛化能力。